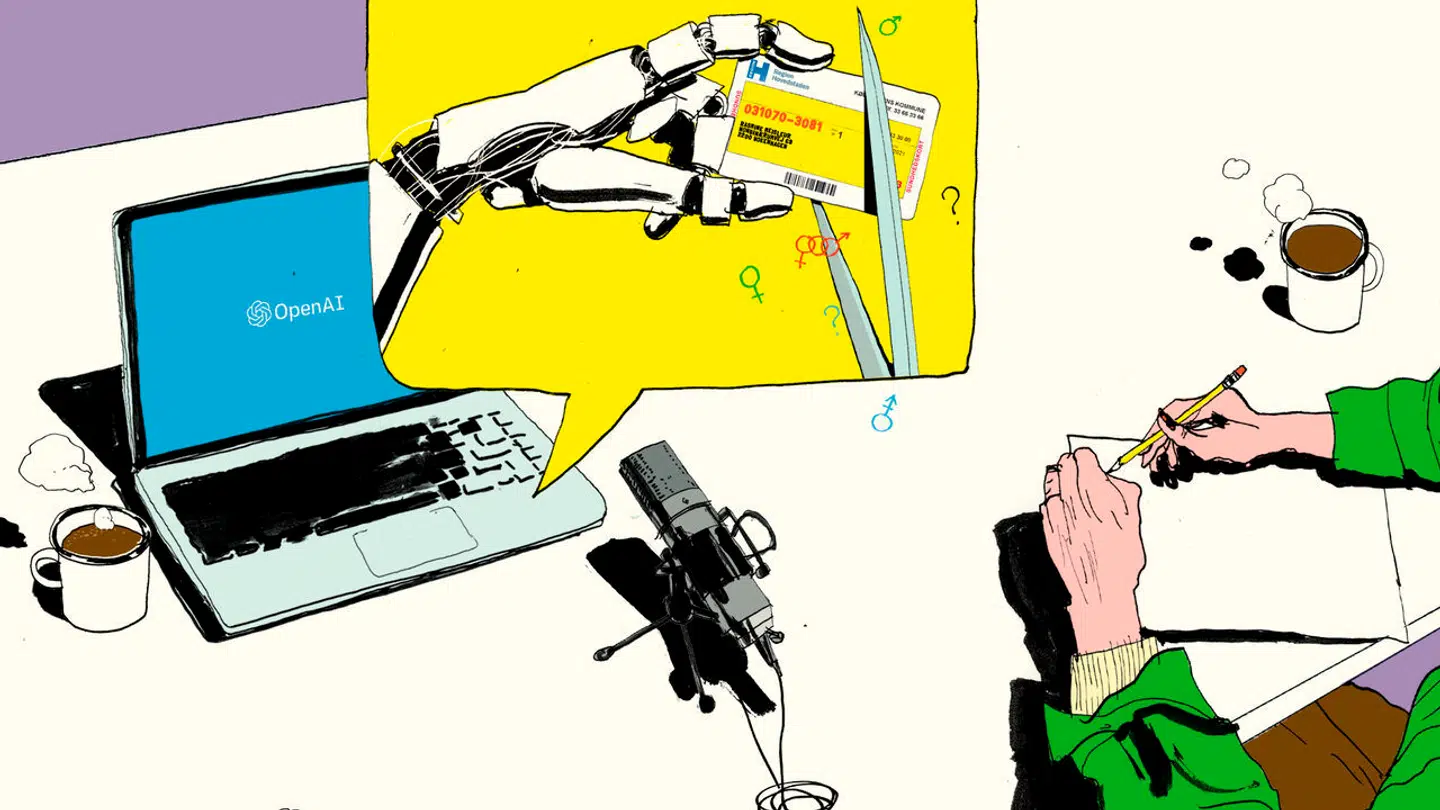

Bias. Det er matematisk umuligt at lave en algoritme, der både er retfærdig på individniveau og afspejler virkeligheden korrekt.

Virkeligheden ifølge Google Translate

Man behøver ikke at lede længe i systemer som Google Translate eller ChatGPT for at finde ud af, at de rummer såkaldt algoritmisk bias, hvor fordomme om køn og etnicitet sniger sig ind i de svar, brugerne præsenteres for.

Får man eksempelvis ChatGPT til at skrive fiktive historier, gør den sygeplejersker og sekretærer til kvinder, mens direktører og læger er mænd. Hvis Google Translate skal oversætte sætningen »Min kæreste er hysterisk« til engelsk, bliver det kønsneutrale »kæreste« oversat til »girlfriend« – gæt selv, hvordan det går, hvis sætningen er »min kæreste er læge«.

Del: